Sie heissen SGR-A1 oder Super aEgis II. Äusserlich unterscheidet sie wenig von konventionellen Geschütztürmen. Doch in ihrem Inneren bahnt sich eine Revolution an. Es handelt sich um die ersten vollautomatischen und vermutlich autonomen Kriegsroboter der Welt. Mit Wärmebildkameras und anderen Sensoren sowie einem Maschinengewehr ausgestattet bewachen sie die Grenze zwischen Nord- und Südkorea. Dort können sie Menschen in bis zu drei Kilometer Entfernung entdecken, Alarm auslösen und die Aufforderung zur Umkehr per Band abspielen. Zwar heisst es, ein Mensch müsse dann den Schuss auslösen, doch die genaue Funktionsweise und die Anzahl Roboter im Einsatz sind streng geheim.

Forderung nach Verbot

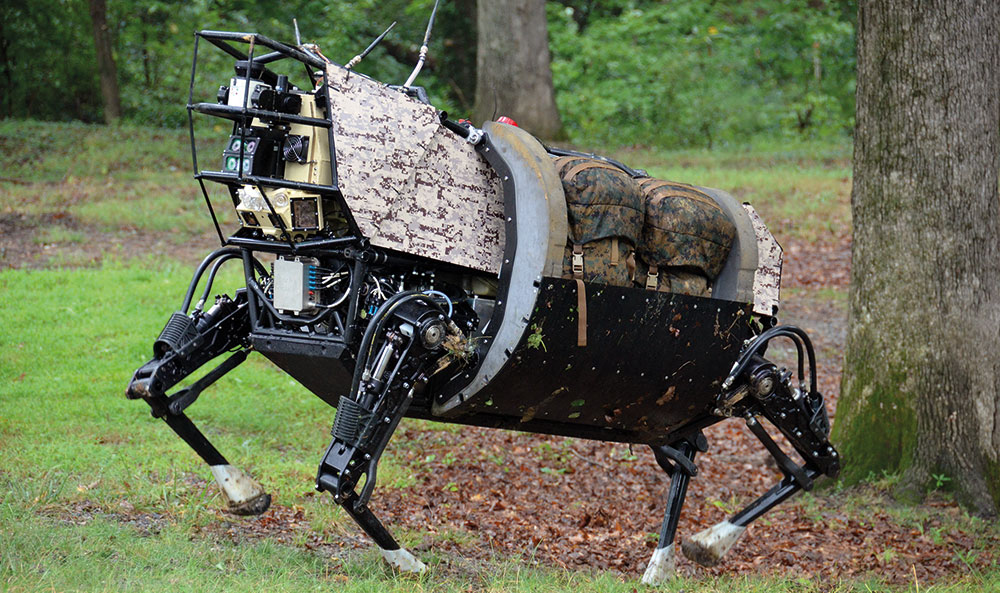

Autonome Kriegsroboter stellen unsere Gesellschaft vor ethische und rechtliche Probleme. Im Gegensatz zu ferngesteuerten Drohnen können sogenannte lethal autonomous weapon systems (LAWS) selbstständig über Leben und Tod entscheiden. Ein Algorithmus soll zum Beispiel zwischen zivilen und militärischen Zielen unterscheiden können und nur bei Bedrohung feuern. Doch diese Aufgabe ist alles andere als trivial.

«Bis jemand einen falschen Alarm erkannt hat, könnten autonome Waffen bereits den Kampf begonnen haben»

«Autonome Roboter besitzen weder menschliches Urteilsvermögen, noch die Fähigkeit, einen Kontext zu verstehen. Diese Qualitäten sind jedoch notwendig, um komplexe ethische Entscheidungen auf dem Schlachtfeld zu fällen», argumentiert die Campaign to Stop Killer Robots (CSKR). Sie will verhindern, dass LAWS die nächsten Drohnen werden: eine Normalität in den zahlreichen Konfliktgebieten. Dies könne nur durch ein sofortiges, von der UN verabschiedetes und überprüfbares Verbot erreicht werden. Die CSKR-Koordinatorin Mary Wareham erklärt in einem Interview: «Bei LAWS gibt es so viele Bedenken, dass ein vollständiges Verbot der Entwicklung, Herstellung und Verwendung dieser Waffensysteme notwendig ist».

Menschliche Kontrolle ist zentral

Auch Human Rights Watch setzt sich für ein absolutes Verbot ein. Die NGO verweist auf die Konflikte mit dem humanitären Völkerrecht. Wer soll und kann für die potentiellen Verbrechen von Kriegsrobotern zur Verantwortung gezogen werden? Die produzierende Firma, eine militärische Vorgesetzte oder gar der Roboter selbst? Wie wichtig die menschliche Kontrolle ist, zeigen zahlreiche Fast-Katastrophen. So zum Beispiel der Fall des kürzlich verstorbenen Stanislav Petrov, der die Welt 1983 womöglich vor einem Nuklearkrieg bewahrte, indem er einen Fehlalarm erkannte.

Kriegsroboter könnten hier weniger zimperlich sein. «Bis jemand einen falschen Alarm erkannt hat, könnten autonome Waffen bereits den Kampf begonnen haben», erklärt Mark Gubrud, Professor im Curriculum in Peace, War & Defense der Universität North Carolina. Darum argumentiert auch Deutschland in einer Stellungnahme am letztjährigen Treffen der UN-Convention on Certain Conventional Weapons, dass es «unabdinglich ist, menschliche Kontrolle über die Entscheidung zu bewahren, einen anderen Menschen zu töten». Zu einem Beschluss kam es jedoch bisher nicht. Nur 19 Staaten haben sich offiziell für ein Verbot ausgesprochen.

Die Angst vor dem Wettrüsten

Im Dunstkreis der Waffenindustrie gibt es genügend Befürworter von Kriegsrobotern. Sie könnten die «Schwächen» von Menschen kompensieren. Es handle sich primär um eine Technologie zum Schutz der Soldaten, heisst es bei Samsung Techwin, die den SGR-A1 herstellt. Huh Kwang-hak, Sprecher von Samsung Techwin, ist überzeugt: «Der SGR-A1 kann und wird Kriege verhindern.»

Diese Euphorie veranlasste im August 2017 eine Gruppe von mehr als einhundert Technologie-Unternehmer zu einer Warnung: In einem im Internet veröffentlichten Brief an die Vereinten Nationen warnten sie die Weltgemeinschaft, tödliche autonome Waffen – also Kriegsroboter – zu entwickeln und zu gebrauchen. Andernfalls drohe ein Wettrüsten mit LAWS, das nicht bloss in Kriegsgebieten, sondern auch für die zivile Gesellschaft weltweit verheerende Auswirkungen haben könne. Diese Warnung ist umso eindringlicher, da viele der Unterzeichnenden, darunter Elon Musk von Tesla, selbst künstliche Intelligenz entwickeln. Jene also, die am Besten um die Risiken autonomer Technologie wissen. Nach Ansicht der Fachleute hat die Weltgemeinschaft nicht mehr viel Zeit: «Wenn diese Büchse der Pandora geöffnet ist, wird es sehr schwer werden, sie wieder zu schliessen.»